在大数据时代,高效获取和处理数据是每个数据分析师、科研工作者乃至普通用户的核心需求。作为Python生态中最强大的数据处理库,Pandas凭借其灵活的数据结构和丰富的功能,成为数据下载、清洗和分析的首选工具。本文将全面解析Pandas数据下载的高效方法与实战技巧,涵盖环境配置、核心功能、安全优化及未来趋势,助您轻松应对复杂的数据处理场景。

一、Pandas的下载与安装

核心特点

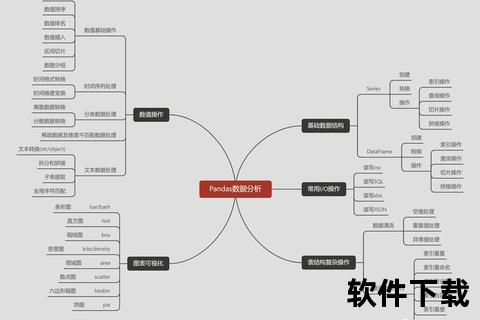

Pandas以高性能、易用性和扩展性著称,支持多种数据格式(如CSV、Excel、JSON、SQL等),并提供数据清洗、转换、聚合等一站式解决方案。其核心数据结构`DataFrame`和`Series`使得处理表格数据变得直观高效。

安装流程

1. 基础安装

bash

pip install pandas>=2.2.0 或 conda install pandas

python

import pandas as pd

print(pd.__version__) 输出版本号即成功

2. 开发环境配置

3. 依赖库安装

为支持更多数据格式和高级功能,建议安装以下扩展库:

bash

pip install openpyxl sqlalchemy pyarrow matplotlib

二、高效数据下载方法

1. 数据读取优化

使用`chunksize`参数分批加载数据,减少内存压力:

python

chunk_iter = pd.read_csv('large_data.csv', chunksize=10000)

for chunk in chunk_iter:

process(chunk) 逐块处理

此方法适合处理超过内存容量的数据集。

通过`usecols`参数仅加载需要的列:

python

df = pd.read_csv('data.csv', usecols=['column1', 'column2'])

可显著减少内存占用和加载时间。

使用`Parquet`或`Feather`等二进制格式替代CSV,提升读写效率:

python

写入Parquet

df.to_parquet('data.parquet')

读取Parquet(速度比CSV快5倍以上)

df = pd.read_parquet('data.parquet')

Parquet支持列式存储和压缩,适合大规模数据。

2. 多数据源支持

通过`sqlalchemy`连接MySQL、PostgreSQL等数据库:

python

from sqlalchemy import create_engine

engine = create_engine('mysql://user:password@localhost/db')

df = pd.read_sql('SELECT FROM table', engine)

支持从AWS S3、Microsoft Fabric Lakehouse等云端存储加载数据:

python

读取Microsoft Fabric Lakehouse数据

df = pd.read_csv('abfss://

还可通过`requests`库获取API数据并转为DataFrame。

三、实战技巧与安全优化

1. 大数据集处理技巧

结合`Dask`或`Polars`库实现分布式计算,突破单机性能瓶颈:

python

import dask.dataframe as dd

ddf = dd.read_csv('large_data.csv')

result = ddf.groupby('category').sum.compute

此方法适合超大规模数据处理。

2. 数据安全与隐私保护

对身份证、电话号码等字段进行掩码处理:

python

df['phone'] = df['phone'].apply(lambda x: x[:3] + '' + x[-4:])

使用`cryptography`库加密数据后再保存:

python

from cryptography.fernet import Fernet

key = Fernet.generate_key

cipher = Fernet(key)

encrypted_data = cipher.encrypt(df.to_csv.encode)

在团队协作中,通过数据库权限或文件系统ACL限制数据访问范围。

四、用户评价与未来展望

用户反馈

未来趋势

掌握Pandas的高效数据下载与处理技巧,不仅能提升工作效率,还能为复杂的数据分析任务奠定基础。从环境配置到实战优化,从安全策略到未来趋势,本文系统梳理了核心知识点。无论是数据分析新手还是资深从业者,合理利用Pandas的强大功能,都能在数据驱动的决策中占据先机。